前言:学不求一次之多,而贵在周周复省。虽然时间很零碎,但也不强求自己能一天学多少,争取每天积累一点就行。

教程:李宏毅(Hung-yi Lee)的Linear Equations视频教程

ppt地址:http://speech.ee.ntu.edu.tw/~tlkagk/courses_LA18.html

视频地址:https://www.bilibili.com/video/av31780632/?p=5

由于想系统而深入学习机器学习的东西,所以将本科没有上过的线代学习一下,所以才有了这个读书笔记。

一开始看到这个英文标题其实有点懵逼,Matrix-Vector product,什么东西来着???

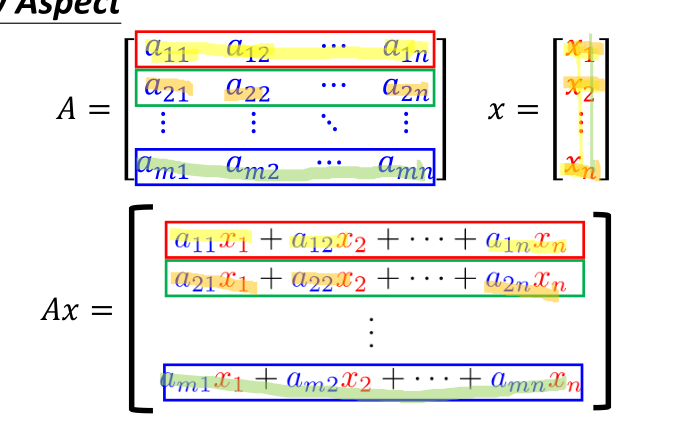

后面看到这张图,才意识到是在讲什么东西

原来是讲矩阵与向量相乘

那么怎么理解这个东西呢?

本来我个人的理解是这样的,矩阵A相对于向量x,其实是一个高维跟低维的,就类似面跟点的关系,通过与A相乘,就是将x以A的维度去衡量x,使得x的有一个更直观的结果呈现在面前。

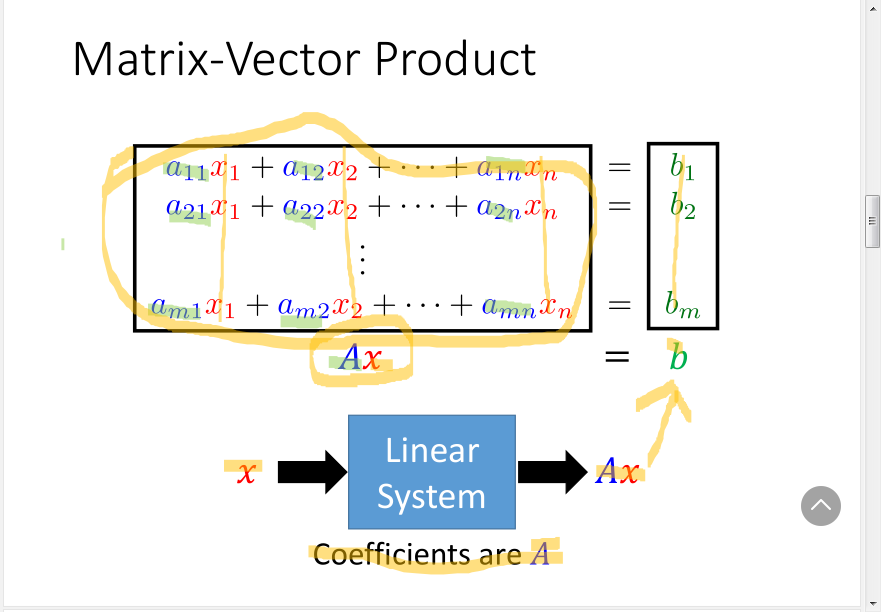

后面李老师提到了Linear System的思维去理解这个东西

emmm,果然是类似的东西

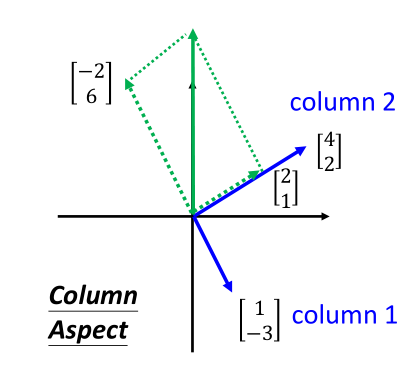

而后李老师又从两个角度对product进行了阐述,分别是row aspect跟column aspect两个层面。

###以解这个两个未知数组的题目为例

x1+4x2=b1

-3x1+2x2 = b2

###这个东西其实就是可以写成矩阵跟向量的相乘的形式

A=[(1,4)(-3,2)]

###而向量则是x1与x2所组成的

x=(x1,x2)

###将x投进A这个Linear System里面,那么当x1等于-2,x2等于0.5时,如何进行评价

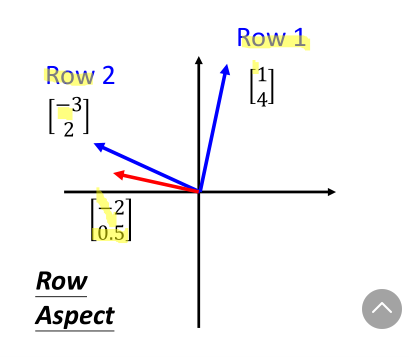

首先是Row aspect

由于row1与x垂直,所以b1明显就为0,而row2与x相乘,结果为7,故而b2就为7

让row1与x相乘,得到(-2,6),让row2跟x相乘,得到(2,1),将这两个向量合起来,正好也是(0,7)

虽然角度不一样,但最终结果是一致的,而计算过程其实正是在矩阵的某一维度中分解之后取合并,这个过程其实理解了就不会很懵逼。

而矩阵能与向量相乘的前提条件,两者必须是matched的,其实也很好理解,只有在矩阵最低维度与向量相同时,两者才可能在一个向量空间中进行运算。

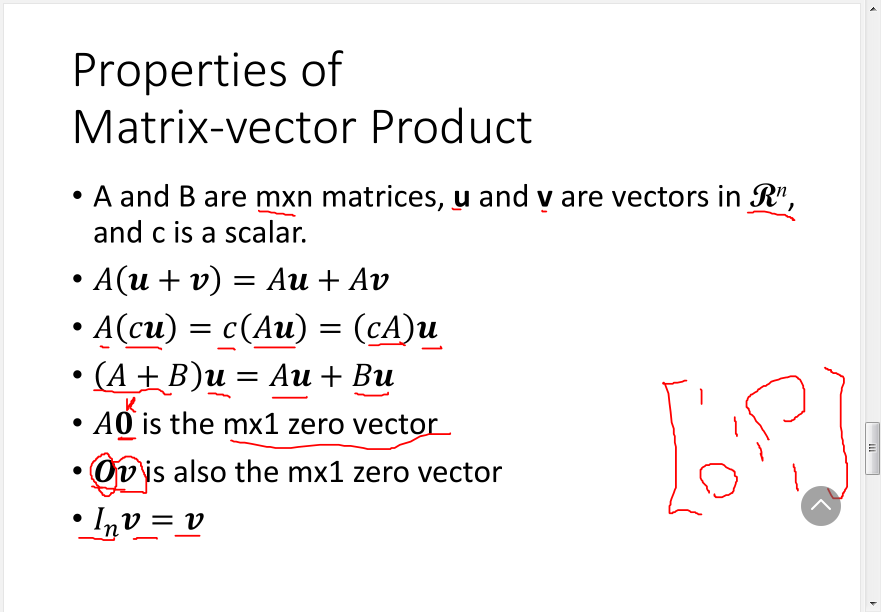

接着就是一些运算的法则,这个其实也蛮容易理解的

最后的话,提到了一个比较有意识的法则,即Ax=Bx,则A与B是相等的,这个其实我还不怎么理解,回头再查查资料